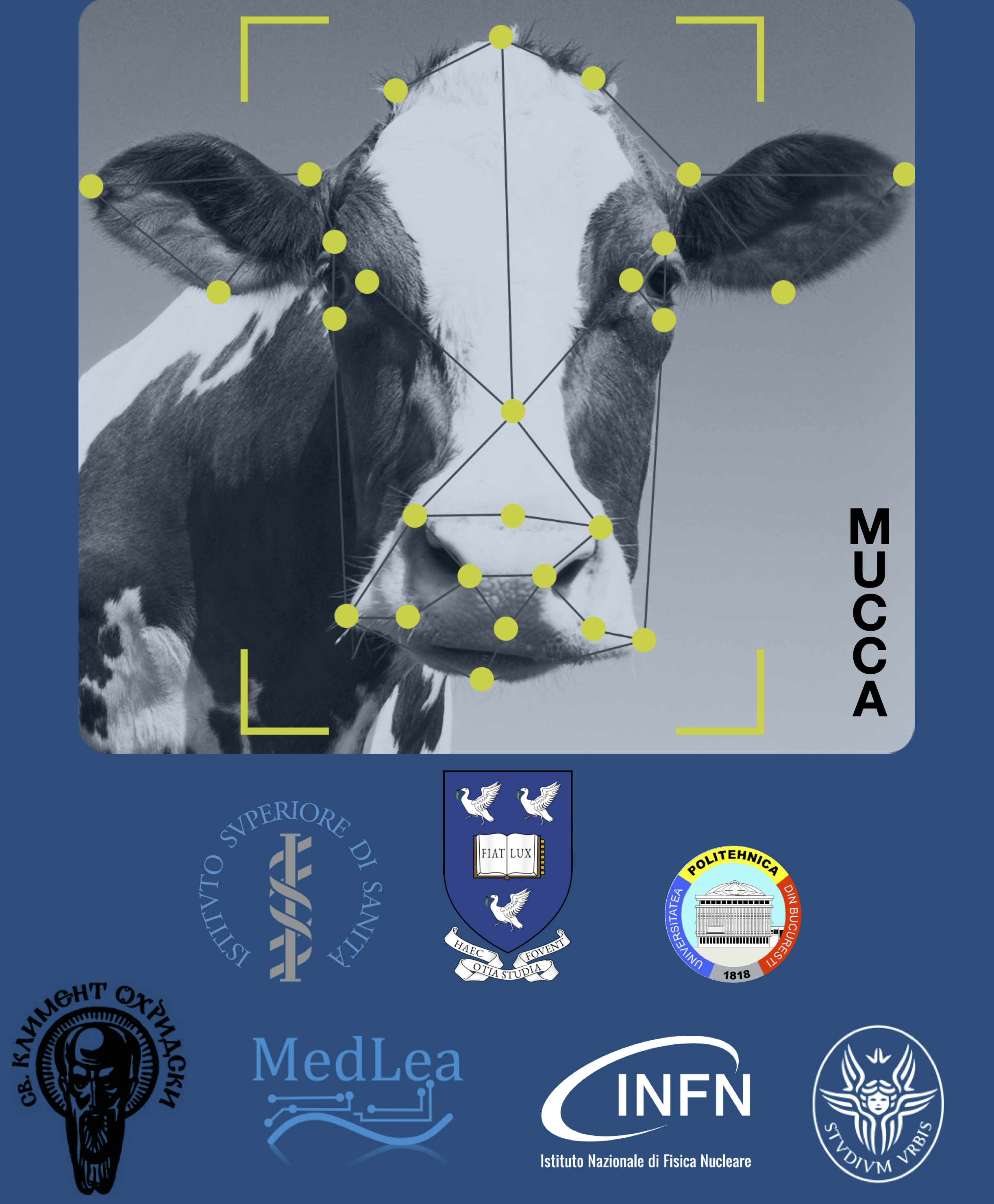

MUCCA

MUCCA - Multi-disciplinary Use Cases for Convergent new Approaches to AI explainability

ID Call: Call 2019 for Research Proposals - Explainable Machine Learning-based Artificial Intelligence

Programma di finanziamento: CHIST-ERA IV - European Coordinated Research on Long-term ICT and ICT-based Scientific and Technological Challenges

Ruolo di Sapienza nel progetto: Coordinatore

Ruolo di Sapienza nel progetto: Coordinatore

Responsabile scientifico per Sapienza: Stefano Giagu

Dipartimento: Fisica

Data inizio progetto: 01/02/2021

Data fine progetto: 31/01/2024

Abstract del progetto:

Lo sviluppo e il test di metodologie che consentano di interpretare le previsioni degli algoritmi di AI in termini di trasparenza, interpretabilità e spiegabilità è diventata oggi una delle questioni aperte più importanti per l’Intelligenza Artificiale.

Lo sviluppo e il test di metodologie che consentano di interpretare le previsioni degli algoritmi di AI in termini di trasparenza, interpretabilità e spiegabilità è diventata oggi una delle questioni aperte più importanti per l’Intelligenza Artificiale.

Il progetto MUCCA riunisce ricercatori di diversi campi con competenze complementari, essenziali per poter comprendere il comportamento degli algoritmi di AI, che verranno studiati su un insieme di casi d'uso multidisciplinari in cui l’AI spiegabile può svolgere un ruolo cruciale e che verranno utilizzati per quantificarne i punti di forza ed evidenziare, e possibilmente risolvere, i punti deboli dei metodi di AI spiegabili disponibili in diversi contesti applicativi. I casi d'uso proposti vanno dalle applicazioni di intelligenza artificiale per la fisica delle alte energie, all’AI applicata all’imaging medico, all’immagine funzionale, e alle neuroscienze. Per ogni caso d'uso, il progetto di ricerca si articola in tre fasi. Nella prima parte, vengono sviluppate e applicate tecniche di spiegabilità all'avanguardia, opportunamente scelte in base ai requisiti dei diversi use-case. Nella seconda parte verranno individuate le carenze delle diverse tecniche, studiati problemi di scalabilità a dati grezzi e ad alta dimensione, in cui il rumore può essere prevalente rispetto al segnale di interesse, e analizzato il livello di certificabilità offerto da ciascun algoritmo. Nella fase finale verranno progettate nuove metodologie algoritmiche e pipeline applicative adeguate ai casi d'uso HEP, medici e neuroscientifici.

Le strutture operative coinvolte sono costituite dal Dipartimento di Fisica (gruppi di fisica applicata e di fisica delle alte energie), dal Dipartimento di Fisiologia e Farmacologia il gruppo di Neuroscienze del comportamento), e il Dipartimento DIET.

Le attività portate avanti nel progetto sono legate allo studio e applicazione di metodologie innovative per spiegare i moderni algoritmi di Intelligenza Artificiale (explainable AI o xAI) in differenti contesti applicativi: fisica delle alte energie, analisi in tempo reale dei segnali, fisica medica applicata, fisica applicata, neuro-scienze. Gli studi e le ricerche proposti implicano sia studi teorici che sviluppi di tipo computazionale e sperimentale che include analisi di dati simulati e dati reali, costruzione di nuovi modelli di AI e definizione e realizzazione di procedure generali end-to-end per l’applicazione dei metodi di xAI in contesti sia di ricerca (di base e applicata), sia in attività sociali e di impresa.